« SE4 IdO sécurité système/réseau » : différence entre les versions

Aucun résumé des modifications |

|||

| (25 versions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 1 : | Ligne 1 : | ||

<!-- | |||

{{SE4CreationConteneur}} | |||

{{SE4ArchitectureMigration}} | |||

{{SE4ArchitectureInnovante}} | |||

--> | |||

{{SEMachinesVirtuelles}} | |||

{{SEReseauPremiereApproche}} | |||

{{SEReseauPremiereRedondance}} | |||

{{SEServicesInternet}} | |||

{{SEReseauSecondeApproche}} | |||

{{SEEffractionWiFi}} | |||

{{SESecurisationsSystemeReseau}} | |||

{ | |||

Version actuelle datée du 12 janvier 2026 à 16:44

Atelier système et réseau, les machines virtuelles

Vous devez installer le système d'exploitation des machines virtuelles destinées à héberger vos services.

Création des machines virtuelles

Comme hyperviseur pour la gestion des machines virtuelles nous utilisons le système Xen. Chaque élève configure sa propre machine virtuelle pour installer ses services.

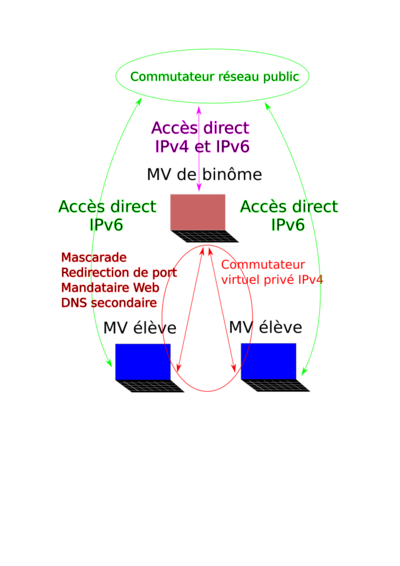

Du au nombre limité d'adresses IPv4 disponibles pour l'atelier, il est nécessaire de créer des machines virtuelles mandataires gérant une adresse IPv4 pour plusieurs machines virtuelles. Partez sur un machine mandataire par binôme.

Les machines de services peuvent contacter Internet et être contactées directement d'Internet via leurs adresses IPv6. Pour contacter Internet en IPv4 les machines de service passent par une mascarade installée sur leur machine mandataire. Pour être contactée d'Internet en IPv4 les machines de services se reposent sur leur machine mandataire qui reçoit les requêtes et qui les redirigent vers la bonne machine de services par des mécanismes dépendant du service accédé (e.g. mécanisme de mandaire inverse pour un service Web).

La connexion IPv4 entre machine de services et machine mandataire se fait par un réseau privé. Chaque type de machine possède donc deux interfaces réseau, une interface dans le réseau routé de la promotion et une interface dans le réseau privé de la machine mandataire. Lisez bien, il doit y avoir un réseau privé par machine mandataire.

Les machines virtuelles sont créées sur le Dom0 capbreton.plil.info.

Pour la création des commutateurs virtuels du réseau routé de la promotion et des réseaux privés vous pouvez :

- modifier le fichier

/etc/network/interfacesdu Dom0 pour décrire le commutateur du réseau routé, ce réseau est effectivement à caractère semi-permanent ; - créer un fichier dans le répertoire

/etc/network/interfaces.ddu Dom0 aux noms du binôme concerné, ce réseau est lui plus transitoire et n'est utilisé qu'un semestre.

Pour la création de la machine virtuelle utilisez la commande xen-create-image. Il vous faut préciser à cet utilitaire le nom de votre machine (choisissez un thème commun), une méthode de configuration IP (prenez DHCP dans un premier temps, vous configurerez le fichier /etc/network/interfaces ensuite), le commutateur virtuel sur lesquel accrocher l'interface réseau et le répertoire où les disques virtuels doivent être créés (imposez /usr/local/xen). Il n'est pas inutile de préciser la taille du disque virtuel (autour de 10G). Laissez le script créer un mot de passe fort. Si vous oubliez le mot de passe vous pourrez le retrouver dans le fichier de contrôle au nom de votre machine situé dans le répertoire /var/log/xen-tools/. Installez la dernière version de la distribution Devuan.

Configuration de la machine de services

Dans un second temps, créez deux partitions LVM de 10G pour votre machine virtuelle (rappelez le nom de la machine dans le nom des partitions) et modifiez le fichier de configuration de la machine virtuelle de services pour faire en sorte que les répertoires /var et /home de la machine virtuelle soient implantés sur ces partitions LVM. Attention à bien transférer le contenu du répertoire /var dans la nouvelle partition destinée à être montée sous /var. Pour un montage permanent des deux partitions, voyez le fichier des montages /etc/fstab.

Modifiez le fichier de configuration /etc/network/interfaces pour faire en sorte que votre machine de services obtienne automatiquement une adresse IPv6 routée et pour fixer une adresse IPv4 sur le réseau privé de la machine mandataire.

Installez les paquetages nécessaires pour ssh, le serveur Web apache2 et le serveur DNS bind (voir la partie services).

Configuration de la machine mandataire

Modifiez le fichier de configuration /etc/network/interfaces pour faire en sorte que votre machine de services obtienne automatiquement une adresse IPv6 routée et pour fixer une adresse IPv4 dans le réseau routé de la promotion.

Installez les paquetages nécessaires pour ssh, le serveur Web apache2 et le serveur DNS bind pour pouvoir mettre en place les mécanismes de redirection évoqués plus haut.

Mettez en place la mascarade et les redirections de ports.

Annexes

Fichier source schéma architecture machines virtuelles : Media:2023_Architecture_MV.svg

Architecture réseau, première approche

Cette section détaille la maquette du réseau que vous devez réaliser rapidement pour que les machines virtuelles puissent être connectées à Internet.

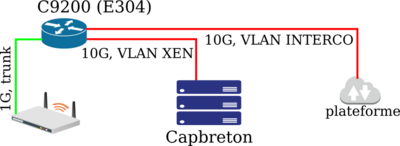

Architecture de base

Vous construirez votre première maquette de réseau autour du routeur C9200 de la salle E304. Ce routeur va devenir le routeur principal.

Un premier réseau virtuel

Nous disposons d'un réseau IPv4 routé et ouvert : 193.48.57.160/27 (dans le VLAN 110 de l’école soit TP-NET1).

Le routage de site (IPv4)

Routez votre VLAN sur votre routeur. Comme vous le savez, la configuration des routeurs doit initialement se faire via leurs ports série ; utilisez minicom sur un ordinateur Linux pour y accéder.

In fine votre routeur va se retrouver sur Internet. Quelques règles de sécurité doivent être appliquées dès maintenant :

- il faut configurer le routeur avec un mot de passe administrateur et pour l'accès SSH ;

- le mot de passe administateur doit être celui de la promotion (i.e. celui de

capbreton) ; - le mot de passe SSH doit aussi être celui de la promotion ;

- seules les machines de l'école doivent pouvoir se connecter en SSH sur le routeur, soit les machines des réseaux

172.26.0.0/16,193.48.57.0/24, cela se fait avec une règle d'accèsaccess-listqui devra être implantée sur les terminaux virtuels du routeurline vtyvia la commandeaccess-class; - aucun serveur Web (HTTP ou HTTPS) ne doit tourner sur le routeur.

Par ailleurs, pour se prémunir de modification intempestives par le service informatique de l'école, vous devez désactiver la configuration automatique des VLAN :

vtp mode transparent

Enfin vérifiez que votre Catalyst C9200 est bien configuré avec la bonne licence :

license boot level network-advantage

Le routage de site (IPv6)

Configurez votre routeur pour permettre à vos machines virtuelles de se construire des adresses IPv6.

Vous pouvez utiliser un sous-réseau de 2001:660:4401:60a0::/60 ou de 2001:660:4401:60b0::/60.

Pour vous aider, voici un extrait de configuration IPv6 sur une interface du routeur de la plateforme maths/info :

interface ... ... ipv6 enable ipv6 address 2001:660:4401:60A0::/64 eui-64 ipv6 nd prefix 2001:660:4401:60A0::/64 1000 900 ipv6 nd router-preference high ... !

En ce qui concerne la configuration globale un simple

ipv6 unicast-routing

va faire l’affaire.

Interconnexion avec Internet (IPv4)

Interconnectez votre routeur de site avec celui de la plateforme. Vous utiliserez comme VLAN d’interconnexion, le VLAN 530 (INTERCO-4A) associé au réseau IPv4 192.168.222.64/28. Le routeur de la plateforme utilise la première adresse disponible.

Faites en sorte que les deux routeurs s’échangent leurs routes par le protocole de routage OSPF. Le routage par OSPF se déclare par un bloc du type ci-dessous où @IPv4 est la plus petite adresse IPv4 du routeur :

router ospf 1 router-id @IPv4 !

Dans ce bloc vous devez ajouter une directive redistribute pour indiquer quel type d'entrées de routage vous souhaitez propager par OSPF et avec quelle métrique. Vous devez aussi ajouter une directive network pour indiquer par quel réseau IPv4 vous passez pour propager et recevoir les annonces, ici c'est le réseau IPv4 du VLAN 530.

Attention ! Le masque pour network est inversé.

Attention ! Il faut aussi que l'area corresponde à celle du pair OSPF. Le routeur de la plateforme utilise area 10.

Attention ! Vos réseaux non routés ne doivent pas sortir par OSPF, rajoutez donc un filtre dans le bloc OSPF, par exemple :

router ospf 1 ... summary-address 10.0.0.0 255.0.0.0 not-advertise ... !

Interconnexion avec Internet (IPv6)

Les VLAN d’interconnexion pour IPv6 sont les mêmes que pour IPv4. Le réseau IPv6 utilisé sur INTERCO-4A est le réseau local IPv6 standard FE80::0/10. Le routeur de la plateforme utilise la première adresse disponible.

Pour interconnecter votre routeur, en ce qui concerne IPv6 cette fois, vous utiliserez RIPv6. Pour vous donner une base de départ voici la configuration RIPv6 du routeur de la plateforme concernant votre réseau de travaux pratiques :

ipv6 router rip tpse redistribute connected metric 1 redistribute rip 1 metric 1 redistribute static metric 1 !

N’oubliez pas d’activer le protocole RIPv6 sur l’interface interconnexion avec une commande du style ipv6 rip tpse enable.

Testez votre connectivité IPv6 en utilisant les serveurs de google.com.

Annexe

Fichier source schéma architecture "Basique" : Media:2026_SE_Architecture_Reseau_Basique.svg

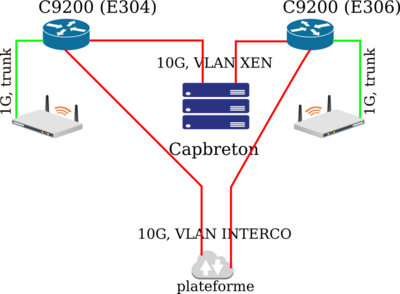

Architecture réseau, redondance de routeurs

Cette section détaille une maquette du réseau plus évoluée avec un second routeur pouvant prendre le relai du routeur principal si celui-ci vient à faillir.

Architecture de base

Vous allez principalement ajouter dans votre réseau le router C9200 se situant en E306. Ce routeur sera le routeur de secours.

Vous allez aussi ajouter deux points d'accès WiFi. L'idéal serait de connecter chaque point d'accès sur les deux routeurs C9200 mais les points d'accès fourni n'ont qu'une interface Ethernet. Vous allez donc simplement attacher chaque point d'accès sur un C9200 différent.

Les deux routeurs auront les mêmes connexions : une connexion vers le serveur de virtualisation, une connexion vers un point d'accès et une connexion vers le réseau d'interconnexion avec le routeur de la plateforme.

Les réseaux virtuels

Vous devez ajouter un VLAN personnel par élève dans votre réseau de promotion. Associez un réseau IPv4 (e.g. un sous-réseau de 10.60.0.0/16) et un réseau IPv6 (e.g. un sous-réseau de 2001:660:4401:60a0::/60 ou de 2001:660:4401:60b0::/60) aux nouveaux VLAN. Ces VLAN seront utilisés pour connecter les clients WiFi de chaque élève.

Il est demandé d’établir un tableau listant tous les VLAN de votre réseau avec les adresses IPv4 et IPv6 utilisées par les routeurs dans chaque VLAN.

Utilisez VRRP pour votre VLAN sous IPv4 et une annonce de routeur pour votre VLAN sous IPv6.

Le routage de site (IPv4)

Configurez votre routeur de secours comme le principal, mais avec des adresses IPv4 propres différentes.

Le routage de site (IPv6)

Configurez votre routeur de secours comme le principal, mais avec des annonces de routeurs IPv6 moins prioritaires.

Interconnexion avec Internet (IPv4)

Configurez votre routeur de secours sur le réseau d'interconnexion avec le protocole OSPF comme pour le routeur principal.

Jouez sur l’option metric de la commande redistribute pour faire en sorte que le routeur principal soit l’élément IPv4 prioritaire de votre réseau.

Interconnexion avec Internet (IPv6)

Configurez votre routeur de secours sur le réseau d'interconnexion avec le protocole RIPv6 comme pour le routeur principal.

Jouez sur l’option metric de la commande redistribute pour faire en sorte que le routeur principal soit l’élément IPv6 prioritaire de votre réseau.

Redondance du réseau

Pour rendre votre réseau plus robuste, faites en sorte que les machines virtuelles utilisent un routeur fonctionnel en implantant le protocole VRRP sur vos deux routeurs. Pour vous donner une idée de départ voici une configuration VRRP typique :

RTR-A(config)# int fa0/1 RTR-A(config-if)# ip address 10.10.10.1 255.255.255.0 RTR-A(config-if)# vrrp 1 ip 10.10.10.3 RTR-A(config-if)# vrrp 1 preempt RTR-A(config-if)# vrrp 1 priority 110

RTR-B(config)# int fa0/1 RTR-B(config-if)# ip address 10.10.10.2 255.255.255.0 RTR-B(config-if)# vrrp 1 ip 10.10.10.3 RTR-B(config-if)# vrrp 1 preempt RTR-B(config-if)# vrrp 1 priority 100

Comment le routeur de la plateforme connaitra le routeur à utiliser pour contacter vos machines ?

Pour certains matériels cisco (e.g. C9200) les commandes ci-dessous peuvent aider :

license boot level network-advantage fhrp version vrrp v3

Annexe

Fichier source schéma architectureé "Redondance1" : Media:2026_SE_Architecture_Reseau_Redondance1.svg

Services Internet

Le but est ici de configurer sur votre machine des services fonctionnels et sécurisés. Les accès IPv6 doivent être directement gérés par la machine virtuelle de services. Les accès IPv4 doivent être gérés par la machine mandataire.

Serveur SSH

Votre machine virtuelle Xen de services doit être accessible par SSH. Autorisez les accès par l'utilisateur root via le fichier de configuration /etc/ssh/sshd_config et l'option PermitRootLogin.

Pour l'accès avec l'adresse IPv4, effectuez une rediction de ports vers vos machines de services. Vous pouvez utiliser le port 2201 pour la première machine de services et 2202 pour la seconde. La redirection de ports s'effectue en utilisant iptables/nftables.

Serveur DNS

Vous allez réserver un nom de domaine pour associer un nom DNS à chacune de vos adresses IP (les zones inverses devraient, elles aussi, être gérées mais nous n'avons pas la délégation pour ce faire). Il est suggéré d’utiliser le registrar Gandi [http://www.gandi.net}. Une fois le nom de domaine reservé, configurez bind (paquetage bind9) sur votre serveur virtuel de services pour donner les adresses IPv4 et IPv6 correspondant à vos noms de machines. Utilisez l’interface web de votre registrar pour paramétrer votre machine comme serveur DNS principal. Utilisez le serveur DNS de votre binôme comme serveur DNS secondaire.

Comme votre serveur DNS ne peut pas être contacté en IPv4 vous allez configurer la machine mandataire pour servir votre zone en tant que serveur DNS secondaire. Le serveur mandataire se met à jour via le réseau privé du mandataire. Du coup au niveau du registrar vous déclarerez un "glue record" avec l'adresse IPv4 du mandataire et l'adresse IPv6 de la machine de services.

Sécurisation de site Web par certificat

Sur la machine virtuelle de services , configurez apache2 (paquetage du même nom) en mode sécurisé à l’aide d’une clef asymétrique et d’un certificat signé par une autorité de certification (CA). Comme CA, il est conseillé d’utiliser aussi Gandi. Le CA signe un CSR (Certificate Signing Request), vous allez créer vos clefs et le CSR en utilisant l'utilitaire openssl (vous pouvez vous aider du Wiki de Gandi). Une fois le CSR signé par le CA et donc transformé en un certificat vous pourrez configurer apache2 pour gérer du HTTPS sur le port 443. Dans la définition du serveur virtuel pour ce port, il faut insérer la ligne de configuration SSLEngine on. Il faut aussi préciser où se trouve la clef privée du serveur via le mot clef SSLCertificateKeyFile et où se trouve le certificat via le mot clef SSLCertificateFile. Il faut aussi définir la chaîne de certification avec SSLCertificateChainFile.

Faites très attention à la clef privée générée avec openssl si vous la perdez, votre certificat devient inutile. Il est conseillé de la stocker de façon pérenne dans votre machine de services.

Là encore seuls les accès IPv6 peuvent se faire en direct sur votre machine de services. Pour IPv4 vous devez configurer apache2 comme mandataire inverse pour votre site. Pour la fonction mandataire inverse, activez les modules Apache proxy et proxy_http. Dans le fichier de configuration du site vous devez ajouter les directives SSLProxyEngine, ProxyPass et ProxyPassReverse (utilisez l'URL avec le nom de domaine dans les deux dernières directives).

Sécurisation de serveur DNS par DNSSEC

Sécurisez votre serveur DNS en signant la zone correspondant à votre nom de domaine.

Deux méthodes sont disponibles : la gestion manuelle des clefs de chiffrement ou la gestion automatique de ces clefs par bind. Pour les travaux pratiques, il est demandé d'utiliser la gestion automatique. Il est aussi conseillé de regarder la méthode manuelle.

Gestion manuelle des clefs

Vous pouvez vous appuyer sur le document [1] pour réaliser la sécurisation. Testez votre configuration avec l’outil [2].

Pour entrer dans les détails, vous allez devoir effectuer les opération suivantes.

- il est conseillé de créer un répertoire de nom

<nom_de_zone>.dnssecpour y générer les clefs ; - créez la clef asymétrique de signature de clefs de zone (pour accélerer la génération sur un système de test vous pouvez utiliser l’option

-r /dev/urandom) ;

dnssec-keygen -a RSASHA256 -b 2048 -f KSK -n ZONE <nom_de_zone>

- créez la clef asymétrique de la zone pour signer les enregistrements (pour accélerer la génération sur un système de test vous pouvez utiliser l’option

-r /dev/urandom) ;

dnssec-keygen -a RSASHA256 -b 1024 -n ZONE <nom_de_zone>

- renommez les deux paires de clefs obtenues en utilisant le nom de la zone comme préfixe puis en suffixant d’abord par la destination de la clef (

-kskpour la KSK ou-zskpour la ZSK) puis par le type de clef (.keypour la clef publique ou.privatepour la clef privée) ; - incluez les clefs publiques dans votre fichier de zone, incrémentez le numéro de version de la zone ;

$include /etc/bind/<nom_de_zone>.dnssec/<nom_de_zone>-ksk.key $include /etc/bind/<nom_de_zone>.dnssec/<nom_de_zone>-zsk.key

- signez les enregistrements de la zone ;

dnssec-signzone -o <nom_de_zone> -k <nom_de_zone>-ksk ../<nom_de_zone> <nom_de_zone>-zsk

- modifiez le fichier

named.conf.localpour utiliser la zone signée de suffixe.signed; - il ne reste plus qu’à communiquer la partie publique de la KSK (présente dans le fichier

<nom_de_zone>-ksk.key) à votre registrar (par exemple Gandi, regardez à "Manage DNSSEC" dans la section "DNS servers").

Gestion automatique des clefs

Rajoutez le bloc suivant dans la définition de vos zones :

key-directory "/etc/bind/keys"; dnssec-policy "dnspol"; inline-signing yes;

La ligne dnssec-policy "dnspol"; fait référence au bloc global ci-dessous.

dnssec-policy "dnspol" {

keys {

ksk key-directory lifetime unlimited algorithm 13;

zsk key-directory lifetime unlimited algorithm 13;

};

nsec3param;

};

Vous avez aussi à communiquer la partie publique de la KSK à votre registrar comme pour la gestion manuelle.

Filtrage des services

Vérifiez dans les fichiers de contrôle de vos machine virtuelle que le port ssh est bien sujet à des attaques par force brute.

Installez un système pour bannir les machines sources des attaques les plus patentes (avec l’utilitaire fail2ban par exemple).

Traitez aussi les attaques sur votre serveur DNS (via le protocole TCP uniquement).

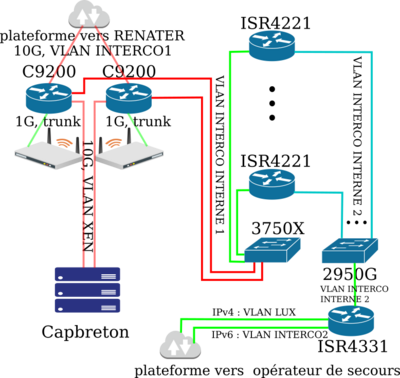

Architecture réseau, finalisation

L’architecture complète

Vous allez tenter de rendre redondant aussi l'accès à Internet. Dans la solution précédente seuls les routeurs sont redondants. L'opérateur Internet reste unique.

Vous allez utiliser les ISR4221 du local technique SR31 pour assurer une connexion de secours à Internet, en IPv4 comme en IPv6, via un fournisseur d’accès secondaire. La connexion de secours n'est à prévoir que pour les machines virtuelles.

Les ISR4221 doivent être connectés via deux réseaux IP d'interconnexion interne au reste de votre réseau de TP. Le premier réseau d'interconnexion permet la communication entre les réseau déjà réalisé et les ISR4221. Le seconde réseau d'interconnexion permet la connexion avec un nouveau routeur ISR4331 à installer en SR31. Ce routeur commun a pour mission de réaliser une mascarade IPv6 et du routage IPv6.

Les deux réseaux d'interconnexion étant internes, il est à votre charge de les définir entièrement, c'est à dire en définissant les VLAN, les réseaux IPv4 et les réseaux IPv6. L'absence de plus de précision n'est pas un défaut du sujet, mais une vérification de votre capacité de réflexion en tant qu'élève-ingénieur.

Le routeur commun ISR4331 est aussi connecté au VLAN de l'opérateur Internet secondaire pour IPv4 et à un second VLAN d'interconnexion avec les routeurs de la plateforme pour IPv6.

Configuration basique des ISR4221 (IPv4)

Donnez des adresses IPv4 à vos ISR4221 sur les deux réseaux d'interconnexion interne.

Configuration basique des ISR4421 (IPv6)

Donnez des adresses IPv6 à vos ISR4221 sur les deux réseaux d'interconnexion interne.

Configuration du routeur ISR4331 commun (IPv4)

Concernant IPv4, l'accès de secours à Internet utilisera une mascarade.

Le réseau virtuel de la liaison fibre orange se trouve sur le VLAN 510 (LUX). Le réseau IPv4 de ce VLAN est 195.101.204.144/28. Le routeur orange utilise l'adresse la plus haute disponible. Vous pouvez utiliser une adresse IPv4 à partir de 195.101.204.150 pour votre mascarade commune. Attention, il est bien spécifié une seule adresse pour l'ensemble de la promotion.

Configuration du routeur ISR4331 commun (IPv6)

Concernant IPv6, l'accès de secours à Internet se fera par 64 réseaux IPv6 pris dans la plage d'adresses 2a01:c916:2047:C8C0::/58. Il est prévu de router ces réseaux à partir d'un routeur de la plateforme vers la machine utilisant la seconde plus petite adresse locale utilisable sur le VLAN 532. Le routeur de la plateforme est sensé utiliser la plus petite adresse locale utilisable dans ce réseau.

Vous avez donc toutes les informations nécessaires pour donner une adresse IPv6 à l'ISR4331 dans le VLAN 532. C'est aussi le cas pour configurer la route par défaut sur ce routeur.

Enfin il vous faut donner une adresse IPv6 à l'ISR4331 dans le second réseau d'interconnexion interne et définir les routes IPv6 statiques vers vos ISR4221.

Interconnexion Internet de secours (IPv4)

Sur le premier réseau d'interconnexion interne, configurez deux instances VRRP, une pour les routeurs centraux, une pour les ISR4221. Installez une route statique sur les ISR4221 pour router le réseau IPv4 des machines virtuelles vers les routeurs centraux.

Sous IOS XE, la syntaxe VRRP diffère en ce qu’il existe un mode de configuration VRRP et que le mot clef ip devient address.

Il reste à mettre en place un mécanisme pour basculer vers l'opérateur de secours en cas de défaillance du principal :

- utiliser le mécanisme SLA sur les routeurs centraux pour ajouter une route IPv4 par défaut :

- cette route doit mener vers l'ISR4221 prioritaire,

- la métrique de cette route doit être plus faible que la route par défaut OSPF ;

- utiliser une mascarade sur les ISR4221 pour sortir vers l'ISR4331 ;

- implanter des redirections de port sur l'ISR4331 pour que vos machines mandataires puissent être contactables via l'opérateur secondaire en IPv4.

Interconnexion Internet de secours (IPv6)

Vous allez mettre en place une vraie translation d'adresses sur vos ISR4221 entre le préfixe IPv6 RENATER utilisé sur le réseau des machines virtuelles et des préfixes que vous choisirez dans la plage 2a01:c916:2047:C8C0::/58 de l'opérateur secondaire. Chaque ISR4221 doit utiliser un réseau IPv6 différent de l'opérateur secondaire.

Pour la communication vers Internet, il vous suffit d'envoyer les paquets IPv6, après translation d'adresse, vers l'ISR4331 qui va se charger de les transmettre au routeur de la plateforme qui lui même propagera à l'opérateur secondaire.

Pour la communication en provenance d'Internet l'ISR4331 va propager les paquets vous concernant à votre ISR4221.

Pour la communication sur le premier réseau d'interconnexion interne vous utiliserez des annonces RIPv6 :

- sur les routeurs centraux annoncez le réseau IPv6 des machines virtuelles sur ce réseau ;

- les ISR4221 annoncez la route IPv6 par défaut sur le mếme réseau ;

- chaque ISR4221 doit annoncer une route par défaut avec une métrique différente ;

- ces métriques doivent être strictement supérieures à la métrique RIPv6 conduisant vers l'opérateur principal.

Pour basculer vers l'opérateur de secours en IPv6 utilisez un mécanisme SLA augmentant la métrique RIPv6 de l'opérateur principal au delà de la plus grande métrique RIPv6 des ISR4221.

Avec ces mécanismes, les accès IPv6 doivent fonctionner vers Internet mais aussi d'Internet vers vos machines virtuelles.

Annexe

Fichier source schéma architecture "Redondance" : Media:2023_SE_Architecture_Reseau_Redondance.svg

Fichier source schéma architecture "Redondance2" : Media:2026_SE_Architecture_Reseau_Redondance2.svg

Effraction WiFi

Vous allez testez dans cette section les méthodes de sécurisation du WiFi.

Cassage de clef WEP d’un point d’accès WiFi

Repérez le nom du réseau sans fil cracotte correspondant à votre binôme (réseau diffusé par le point d’accès Cisco présent dans la salle). Installez le paquetage aircrack-ng et utilisez-le pour trouver la clef WEP associée à votre réseau. Il faudra commencer par trouver le point d’accès (canal, nom des réseaux) puis écouter les trames WiFi avec airodump-ng (la carte WiFi étant passée en mode écoute à l’aide de l’utilitaire airmon-ng). Une fois suffisament de trames échangées, lancez l’algorithme de craquage de la clef WEP (aircrack-ng).

Cassage de mot de passe WPA-PSK par force brute

Utilisez les outils du paquetage aircrack-ng pour lancer une recherche sur le mot de passe de l’identification par WPA-PSK. Repérez le nom du réseau sans fil kracotte correspondant à votre binôme (réseau diffusé par le point d’accès Cisco présent dans la salle). Capturez des dialogues d’identification WPA avec airodump-ng. Attention pour capturer ces paquets d’identification vous devez être à bonne distance du point d’accès du banc d’essai. L’utilitaire indique en haut de son affichage si de telles trames sont capturées. Une fois chose faite, lancez aircrack-ng pour tenter de craquer la clef WPA. Le craquage doit se faire avec l’aide d’un dictionnaire. On va donc supposer que la clef WPA est un nombre sur 8 chiffres. En conséquence, créez un dictionnaire de toutes les clefs de ce format et lancez aircrack-ng.

Sécurisations

Dans cette dernière section vous devez sécuriser, au sens sécurité contre les instrusions, des mécanismes système ou réseau.

Chiffrement de données

Sur votre machine virtuelle ajoutez une partition de quelques Go. Sécurisez la partition en utilisant l’utilitaire cryptsetup (choisissez le type plain), créez un système de fichiers au dessus de la partition sécurisée (faite un tour dans le répertoire /dev/mapper pour trouver le périphérique correspondant) et montez-le à la main. Ajoutez des données sur ce système de fichiers. Rebootez votre machine virtuelle, tentez à nouveau de lire les données. Essayez d'automatiser le montage de la partition chiffrée.

Sécurisation WiFi par WPA2-EAP

Le but est de faire en sorte que l’accès à la borne WiFi soit controlé par WPA2-EAP. L’identification va se faire en utilisant un serveur FreeRadius.

En résumé vous effectuer les actions décrites ci-dessous.

- Faire que les points d'accès soient connecté avec les routeurs centraux via le VLAN1.

- Faire que les routeurs centraux gèrent une adresse virtuelle IPv4 dans le VLAN1 par VRRP, utiliser cette adresse virtuelle comme routeur par défaut des points d'accès.

- Faire que les routeurs centraux routent votre VLAN personnel en utilisant VRRP.

- Router, sur les routeurs centraux, le réseau IPv4 de votre commutateur virtuel privé vers votre machine virtuelle mandataire.

- Ajouter à la configuration du point d’accès WiFi un SSID, de même nom que votre machine de services, protégé par la méthode WPA2-EAP. Des exemples de configurations pour point d'accès WiFi sont donnés dans la suite de la section.

- Le précédent SSID doit utiliser le VLAN personnel que vous vous êtes créé dans la partie réseau avancée.

- Configurer, sur votre machine de services, un serveur FreeRadius en PEAP-MSCHAPv2, autoriser le point d'accès WiFi à utiliser le serveur d'identification et créer un utilisateur.

- Implanter un serveur DHCP, pour les adresses d'octet de poids faible

100à200du réseau IPv4 de votre VLAN privé, sur les routeurs centraux (configurez des plages distinctes sur les deux routeurs). Donner l'adresse VRRP des routeurs centraux sur votre VLAN personnel comme routeur par défaut. Utilisez votre serveur DNS. - Implanter une politique de route sur les routeurs centraux (Policy-Based Routing) pour envoyer le flux IPv4 de votre VLAN personnel vers votre machine mandataire, vous pouvez ensuite élargir la mascarade sur la mandataire à votre VLAN personnel.

Vous pouvez tester la visibilité de votre SSID, l'identification WiFi, le serveur DHCP et enfin l'accès à Internet en utilisant votre téléphone portable ou la carte WiFi des zabeth.

Exemple de configuration d'un point d'accès WiFi Cisco sous IOS pour l'élève N :

...

aaa new-model

aaa authentication login eap_studentN group radius_studentN

radius-server host <IPv4_VM_SERVICES_N> auth-port 1812 acct-port 1813 key secret_studentN

aaa group server radius radius_studentN

server <IPv4_VM_SERVICES_N> auth-port 1812 acct-port 1813

!

...

dot11 ssid VM_SERVICES_N

vlan Personnel_N

authentication open eap eap_studentN

authentication network-eap eap_studentN

authentication key-management wpa

mbssid guest-mode

!

...

interface Dot11Radio0

encryption vlan Personnel_N mode ciphers aes-ccm

...

!

...

interface Dot11Radio0.Personnel_N

encapsulation dot1Q Personnel_N

bridge-group Personnel_N

!

interface GigabitEthernet0.Personnel_N

encapsulation dot1Q Personnel_N

bridge-group Personnel_N

!

...